DP-203 試験問題 151

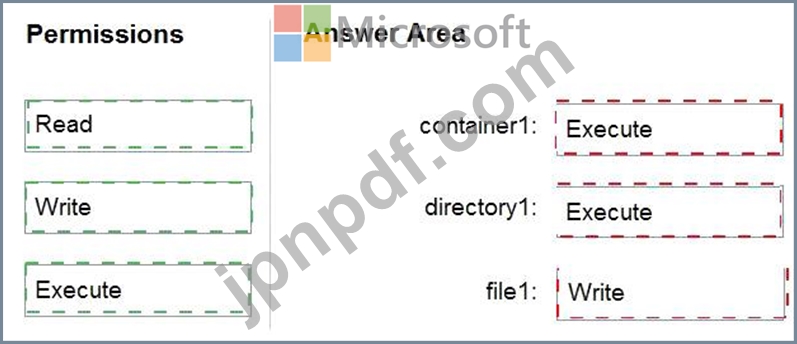

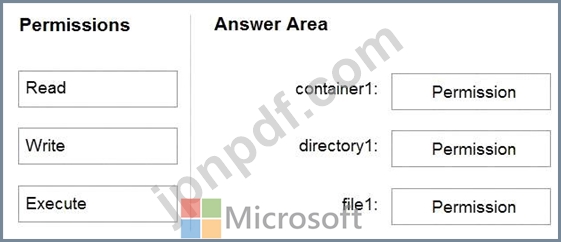

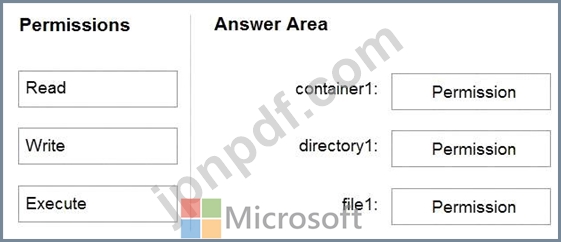

storage1 という名前の Azure Data Lake Storage Gen2 アカウントを含む Azure サブスクリプションがあります。

Storage1 には、container1 という名前のコンテナーが含まれています。Container1 には、directory1 という名前のディレクトリが含まれています。Directory1 には file1 という名前のファイルが含まれています。

User1 という名前の Azure Active Directory (Azure AD) ユーザーがあり、このユーザーには storage1 のストレージ BLOB データ閲覧者ロールが割り当てられています。

User1 が file1 にデータを追加できることを確認する必要があります。ソリューションでは、最小特権の原則を使用する必要があります。

どの権限を付与する必要がありますか? 答えるには、適切な権限を正しいリソースにドラッグします。

各権限は、1 回だけ使用することも、複数回使用することも、まったく使用しないこともできます。コンテンツを表示するには、ペイン間で分割バーをドラッグするか、スクロールする必要がある場合があります。

Storage1 には、container1 という名前のコンテナーが含まれています。Container1 には、directory1 という名前のディレクトリが含まれています。Directory1 には file1 という名前のファイルが含まれています。

User1 という名前の Azure Active Directory (Azure AD) ユーザーがあり、このユーザーには storage1 のストレージ BLOB データ閲覧者ロールが割り当てられています。

User1 が file1 にデータを追加できることを確認する必要があります。ソリューションでは、最小特権の原則を使用する必要があります。

どの権限を付与する必要がありますか? 答えるには、適切な権限を正しいリソースにドラッグします。

各権限は、1 回だけ使用することも、複数回使用することも、まったく使用しないこともできます。コンテンツを表示するには、ペイン間で分割バーをドラッグするか、スクロールする必要がある場合があります。

DP-203 試験問題 152

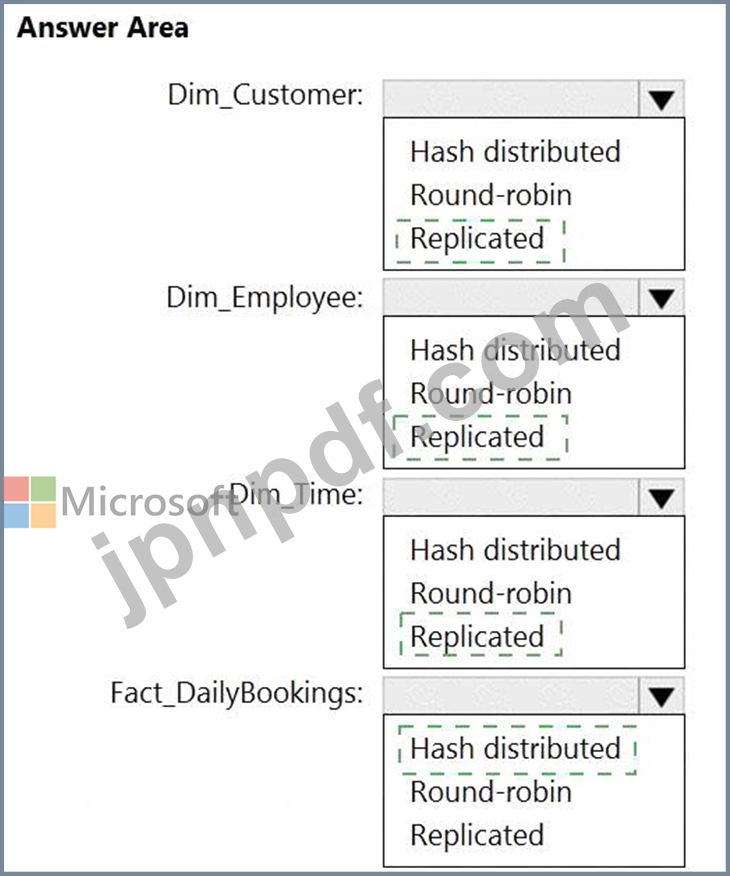

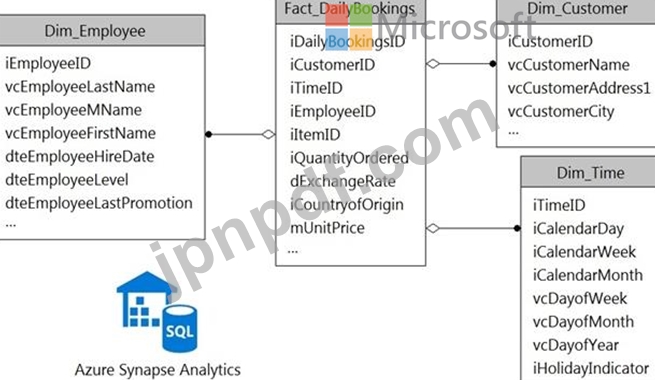

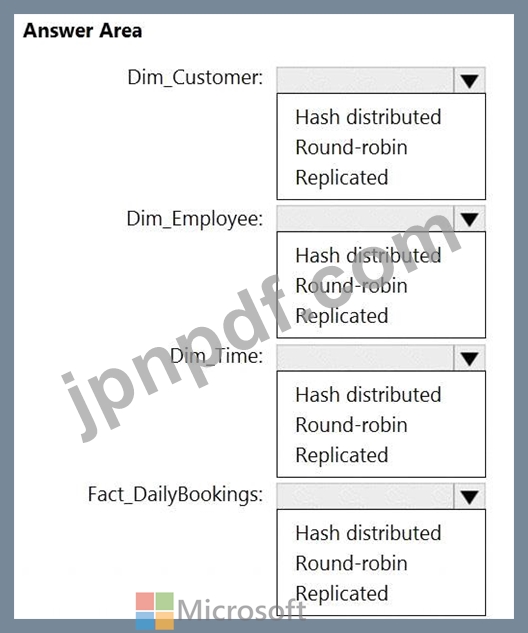

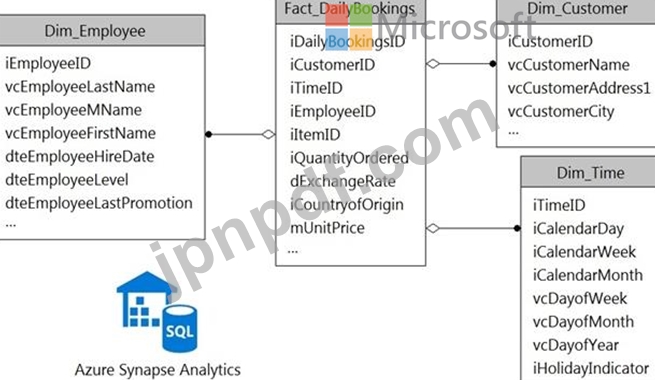

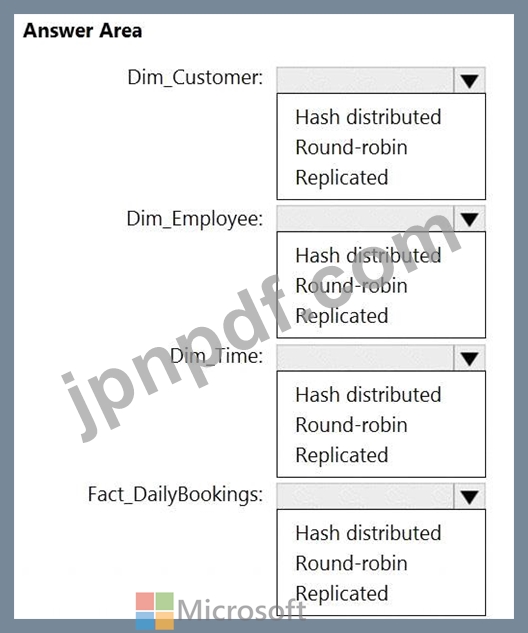

次の図に示すように、Azure Synapse Analytics のデータ ウェアハウスに実装する予定のデータ モデルがあります。

圧縮後のすべてのディメンション テーブルは 2 GB 未満になり、ファクト テーブルは約 6 TB になります。

各テーブルにはどのタイプのテーブルを使用する必要がありますか? 回答するには、回答領域で適切なオプションを選択してください。

注: 正しく選択するたびに 1 ポイントの価値があります。

圧縮後のすべてのディメンション テーブルは 2 GB 未満になり、ファクト テーブルは約 6 TB になります。

各テーブルにはどのタイプのテーブルを使用する必要がありますか? 回答するには、回答領域で適切なオプションを選択してください。

注: 正しく選択するたびに 1 ポイントの価値があります。

DP-203 試験問題 153

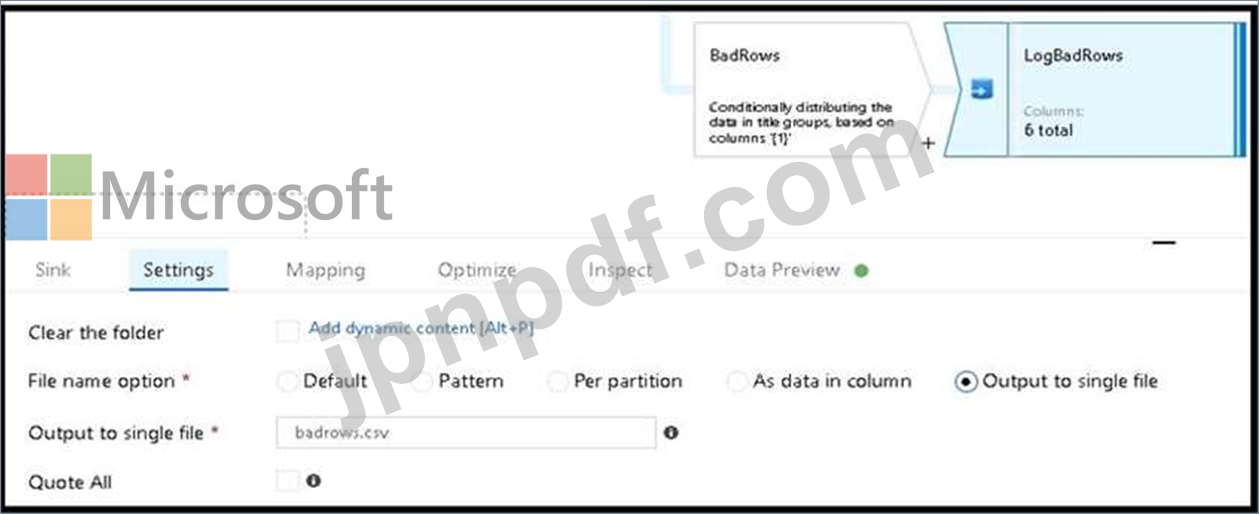

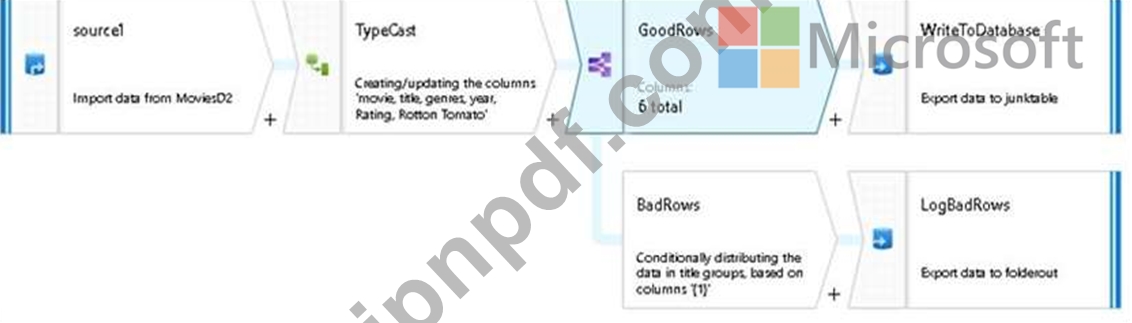

CSV ファイルからデータを取り込み、列を指定された種類のデータにキャストし、そのデータを Azure Synapse Analytic 専用 SQL プールのテーブルに挿入する Azure Data Factory データ フローを作成しています。CSV ファイルには、ユーザー名、コメント、日付という名前の 3 つの列が含まれています。

データ フローにはすでに次のものが含まれています。

ソース変換。

適切なタイプのデータを設定するための派生列変換

a.

データをプールに配置するためのシンク変換。

データ フローが次の要件を満たしていることを確認する必要があります。

すべての有効な行を宛先テーブルに書き込む必要があります。

コメント列の切り捨てエラーは積極的に回避する必要があります。

挿入時に切り捨てエラーが発生するコメント値を含む行は、BLOB ストレージ内のファイルに書き込む必要があります。

どの 2 つのアクションを実行する必要がありますか? それぞれの正解は、解決策の一部を示しています。

注: 正しく選択するたびに 1 ポイントの価値があります。

データ フローにはすでに次のものが含まれています。

ソース変換。

適切なタイプのデータを設定するための派生列変換

a.

データをプールに配置するためのシンク変換。

データ フローが次の要件を満たしていることを確認する必要があります。

すべての有効な行を宛先テーブルに書き込む必要があります。

コメント列の切り捨てエラーは積極的に回避する必要があります。

挿入時に切り捨てエラーが発生するコメント値を含む行は、BLOB ストレージ内のファイルに書き込む必要があります。

どの 2 つのアクションを実行する必要がありますか? それぞれの正解は、解決策の一部を示しています。

注: 正しく選択するたびに 1 ポイントの価値があります。

DP-203 試験問題 154

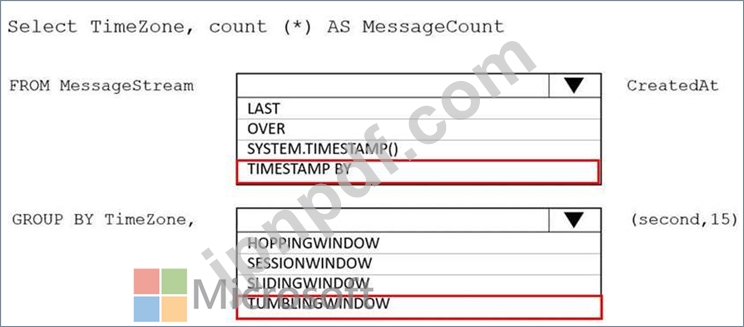

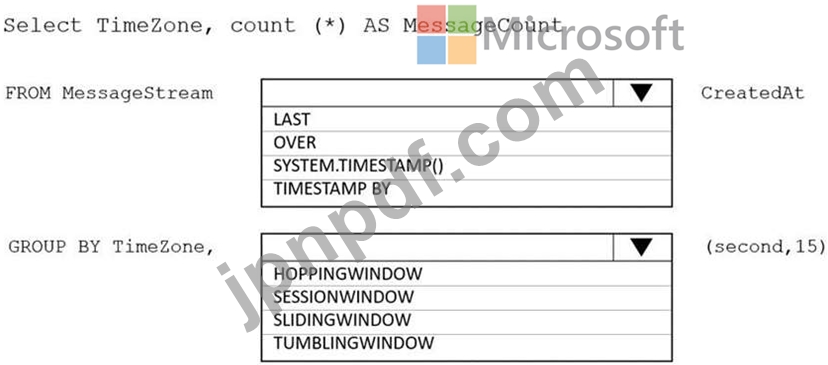

あなたは、Azure Event Hub からインスタント メッセージング データを受信する Azure Stream Analytics ソリューションを設計しています。

Stream Analytics ジョブからの出力で、タイム ゾーンごとのメッセージ数が 15 秒ごとにカウントされていることを確認する必要があります。

Stream Analytics クエリをどのように完了する必要がありますか? 回答するには、回答内の適切な選択肢を選択してください。

注: 正しく選択するたびに 1 ポイントの価値があります。

Stream Analytics ジョブからの出力で、タイム ゾーンごとのメッセージ数が 15 秒ごとにカウントされていることを確認する必要があります。

Stream Analytics クエリをどのように完了する必要がありますか? 回答するには、回答内の適切な選択肢を選択してください。

注: 正しく選択するたびに 1 ポイントの価値があります。

DP-203 試験問題 155

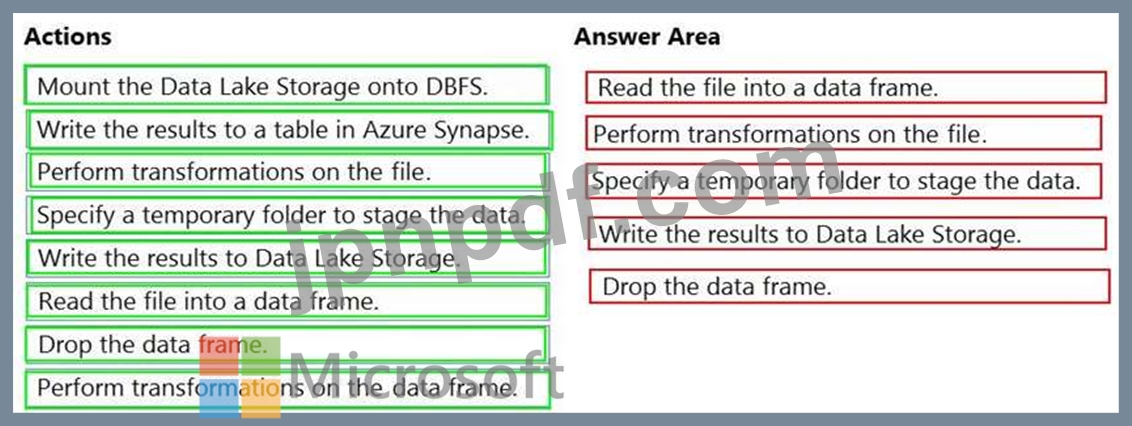

顧客用の JSON ファイルを含む Azure Data Lake Storage Gen2 アカウントを持っています。このファイルには、FirstName と LastName という 2 つの属性が含まれています。

Azure Databricks を使用して、JSON ファイルから Azure Synapse Analytics テーブルにデータをコピーする必要があります。FirstName と LastName の値を連結する新しい列を作成する必要があります。

次のコンポーネントを作成します。

Azure Synapse の宛先テーブル

Azure Blob ストレージ コンテナー

サービスプリンシパル

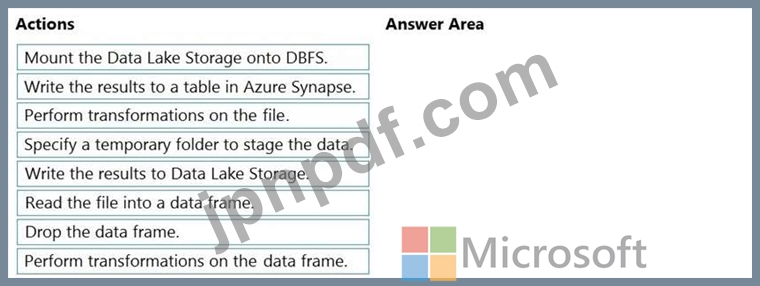

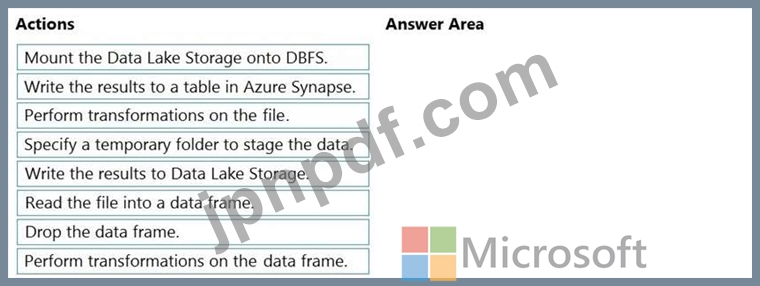

次に Databricks ノートブックで順番に実行する必要がある 5 つのアクションはどれですか? 回答するには、アクションのリストから適切なアクションを回答領域に移動し、正しい順序で並べます。

Azure Databricks を使用して、JSON ファイルから Azure Synapse Analytics テーブルにデータをコピーする必要があります。FirstName と LastName の値を連結する新しい列を作成する必要があります。

次のコンポーネントを作成します。

Azure Synapse の宛先テーブル

Azure Blob ストレージ コンテナー

サービスプリンシパル

次に Databricks ノートブックで順番に実行する必要がある 5 つのアクションはどれですか? 回答するには、アクションのリストから適切なアクションを回答領域に移動し、正しい順序で並べます。